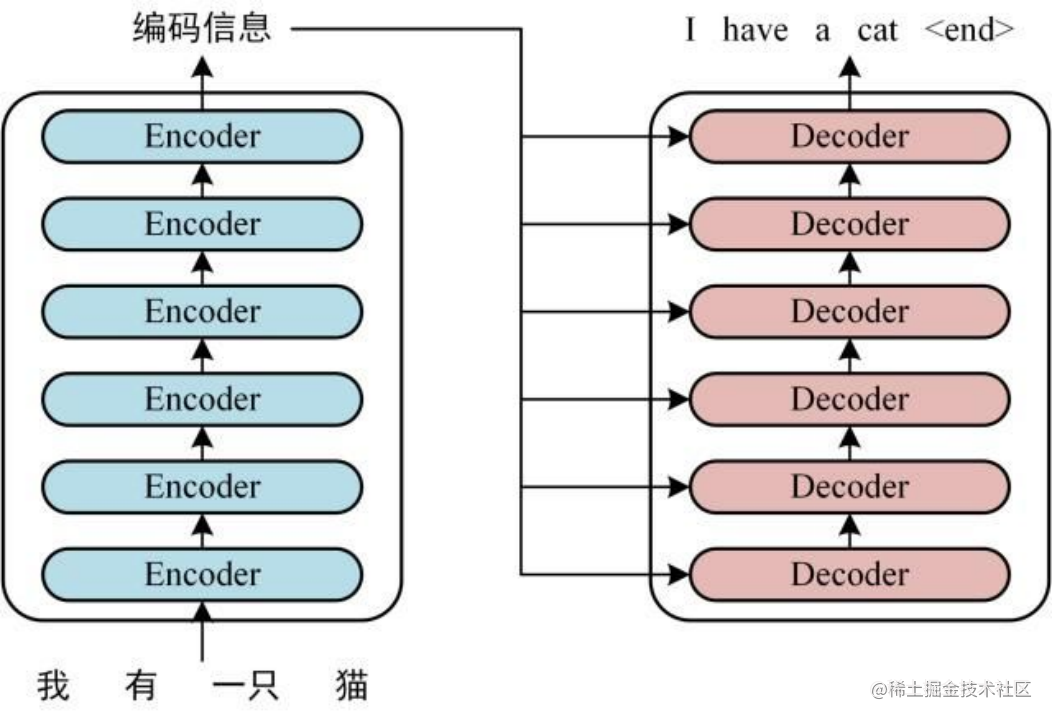

MoE和transformer有什么区别和联系 知乎

MoE和transformer有什么区别和联系 知乎.

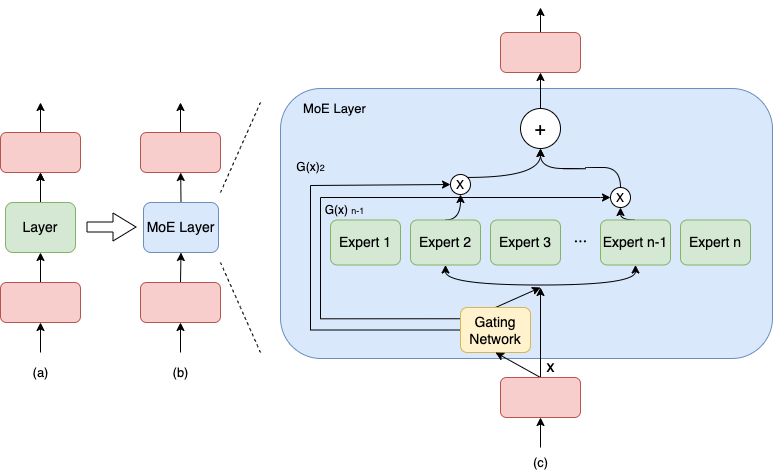

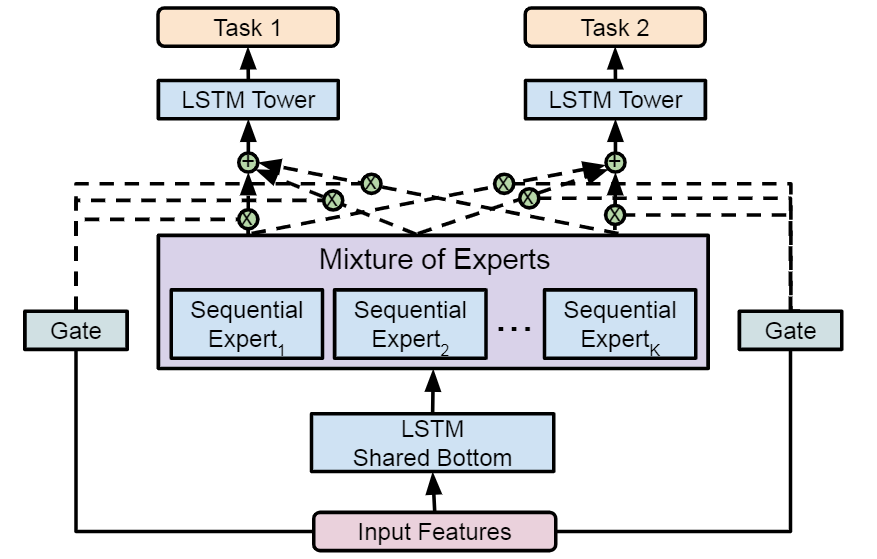

MoEMixtureofExperts架构的大模型具体怎么训练 知乎

MoEMixtureofExperts大模型架构的优势是什么为 知乎

如何看待DeepSeek开源国产MoE大模型DeepSeek MoE 16B 知乎

Margin of Exposure EFSA

阿里通义千问 Qwen3 系列模型正式发布该模型有哪些技术亮点 知乎

如何看待域名 moe萌获得 ICANN 批准 知乎

|

|

|---|

Telefon Azeri porno :MoE MixtureofExperts大模型架构的优势是什么为什么,MoEMixtureofExperts架构的大模型具体怎么训练 知乎,MoEMixtureofExperts大模型架构的优势是什么为 知乎,如何看待DeepSeek开源国产MoE大模型DeepSeek MoE 16B 知乎,Margin of Exposure EFSA,阿里通义千问 Qwen3 系列模型正式发布该模型有哪些技术亮点 知乎,如何看待域名 moe萌获得 ICANN 批准 知乎,如何看待 Google 最新开源的 Gemma3 系列大模型 知乎,如何评价豆包大模型正式发布升级的Doubao15Pro 知乎,如何评价阿里云刚刚发布的Qwen3系列大型语言模型 知乎,